Introduction

Nous sommes 4 élèves de la 1ère S1 du

lycée Marcel Pagnol d’Athis Mons(91200). Nous avons créé ce blog pour

notre TPE traitant des ondes sonores, leur perception et leur

traitement. Avec ce thème, nous essayons de comprendre les

caractéristiques de l’onde sonore, la façon dont elle est perçue et si

elle possède les mêmes propriétés avant et après le traitement.

Tout

d’abord une onde sonore est une vibration de l’air. L’Homme ne peut

percevoir que les ondes sonores de fréquence située entre 20 et 20000

Hz. Pour traiter un son, différentes techniques ont été employées durant

plusieurs années.

Nous

allons donc présenter tout d’abord ce qu’est une onde sonore avec

toutes ses caractéristiques. Parallèlement à cela, nous étudierons

l’oreille humaine, l’organe complexe permettant de percevoir les ondes

sonores. Pour finir, nous allons retracer les diverses techniques de

traitement de son utilisées au fil des années.

Plan du T.P.E :

I) L’onde sonore

A) Définition de l’onde sonore

B) Les caractéristiques du son

1) Hauteur et fréquence

2) Intensité ou amplitude

3) Le timbre

II) Notre perception des ondes sonore

A) Oreille externe

1) Pavillon

2) Conduit auditif

B) Oreille moyenne

C) Oreille interne

III) Enregistrement d’un signal sonore acoustique

A) Méthodes et techniques d’enregistrement

B) Les appareils intervenants lors d’un enregistrement sonore, en détails

C) Quelques différents supports de stockage

IV) Le traitement du son

A) L’échantillonnage

B) Qu’est-ce que la quantification et à quoi sert-elle ?

C) Les différents formats de fichiers son

I) L'onde sonore

A) Définition de l'onde sonore

Une onde sonore est une onde mécanique (« Onde mécanique » sous-entend qu’il y a propagation d’une perturbation de proche en proche, avec le transport d’énergie mais pas de matière) progressive et tridimensionnelle constituée d'une variation de pression crée

par la source sonore dans un milieu compressible comme l’air. Elle se

propage dans l'air à une vitesse de 340m par seconde et à 1500m/s dans

l'eau.

C'est une onde longitudinale (elle provoque une perturbation de direction parallèle à la direction de propagation de l’onde).

Modèle de la propagation de l'onde sonore

Le

son ne se transmet pas seulement dans l'air et dans l'eau, mais, d'une

manière générale, dans tous les milieux matériels (solides, liquides ou

gaz). Le son se propage dans les solides sous forme de vibrations des atomes appelés phonons.

Dans ce cas, seule la vibration se propage, et non les atomes qui ne

font que vibrer très faiblement autour de leur position d'équilibre. Les ondes qui composent le son sont susceptibles de subir des réflexions (phénomène d'écho), des réfractions (transmission à travers une paroi) et des interférences. (En mécanique ondulatoire, on parle d'interférences lorsque deux ondes de même type se rencontrent et interagissent l'une avec l'autre.)

Cependant, l’onde sonore ne se propage pas dans le vide. (Expérience de la cloche à vide).

B) Les caractéristiques d'un son

Il existe 3 paramètres de distinction : La fréquence et la hauteur, l’amplitude et le timbre.

1) La hauteur et la fréquence.

La hauteur est la caractéristique qui fait distinguer un son grave d'un son aigu. La hauteur d'un son est liée à la fréquence (La fréquence est le nombre d’oscillations périodiques par seconde. Elle s’exprime en Hertz (Hz)) des vibrations de la source sonore. Les sons aigus sont dus aux mouvements vibratoires de fréquence élevée, les sons graves aux mouvements de basse fréquence. Toutefois, l'oreille humaine ne peut percevoir que les sons dont les fréquences sont compris entre 20 et 20 000 Hz environ. En dessous de 20 Hz, il s’agit d’infrasons et d’ultrasons au-dessus de 20 KHz. Ceux- ci ne donnent pas lieu à une sensation sonore.

Seuils d'audibilité

2) L'intensité ou l'amplitude.

L’intensité, est une caractéristique qui fait distinguer un son fort d'un son faible. L'intensité est liée à l'amplitude des

vibrations sonores. Toutefois, l'oreille ne peut percevoir un son que

si cette amplitude a une valeur minimale. L'intensité minimale

correspondante s'appelle « seuil d'audibilité ». Si, au

contraire, on fait croître progressivement l'amplitude des vibrations

sonores, l'audition finit par devenir extrêmement pénible. L'intensité

maximale correspondant à la limite du supportable pour l'oreille est

appelée « seuil de douleur ». L’intensité s’exprime en décibels et est comprise entre environ 0dB et 120dB. (dB)

Amplitude faible

Amplitude forte

Il est à remarquer que lorsque l’on augmente un son de 3dB, la puissance du son est multipliée par 2.

>120

|

:

|

niveaux exceptionnels : avions, fusées, explosions

| |

90 - 120

|

:

|

sons nocifs : musique amplifiée, sports mécaniques, bruits industriels

| |

85-90

|

:

|

limite de nocivité pour le système auditif

| |

60 - 80

|

:

|

lieux de vie : magasins, rues, communication parlée

| |

30 - 50

|

:

|

lieux de repos ou de travail intellectuel : chambre, bibliothèque, bureaux

| |

0 - 30

|

:

|

lieux très calmes : campagne, studios d'enregistrement

| |

0 dB

|

:

|

seuil de perception de l'oreille humaine

|

Exemples de puissance sonores.

Nous pouvons également associer l’intensité à la fréquence vue précédemment par les courbes de Fletcher et Munson.

Les courbes dites de Fletcher et Munson ont été établies d'après des

mesures effectuées sur de nombreux individus. Elles prouvent que la

sensibilité de l'oreille n'est pas identique à toutes les fréquences.

Ces courbes représentent la sensibilité moyenne de l'oreille pour une

plage de fréquences données.

courbes Fletcher et Munson

D’une

manière générale, l’oreille est moins sensible aux fréquences graves et

aiguës qu’aux fréquences médiums, comprises entre 1 KHz et 5 KHz, qui

sont naturellement favorisées par notre oreille.

3) Le timbre

Le timbre,

est une "qualité" par laquelle on distingue deux sons émis par deux

instruments différents. Si le son est « musical », au sens acoustique du

terme, c'est-à-dire créé par un mouvement vibratoire périodique, il

peut être donc considéré comme la superposition de sons simples

harmoniques dont les fréquences sont des multiples entiers de la

fréquence du son de base (« fondamental »). Le timbre d'un son dépend

alors des intensités relatives des différents sons simples harmoniques

qui le composent.

Le timbre d’un instrument correspond à sa richesse sonore.Par conséquent,une même note jouée sur deux instruments différents ne donnera pas au final le même son: ceci étant dû aux attaques du son caractérisés par ce qu'on appelle les transitoires d'attaque.

En outre, chaque son est formé à la fois d’une fréquence fondamentale et de fréquences harmoniques. Un son est dit riche, c'est-à-dire agréable à entendre, lorsqu’il contient de nombreuses harmoniques. Un son pauvre en harmoniques paraîtra terne à notre oreille.

Un son ne comprenant qu’une seule fréquence est appelé son pur ( il est sinusoïdal et extrêmement rare dans notre environnement quotidien). Les sons musicaux sont des sons complexes, car on y trouve un mélange de sons graves et de sons aigus. Le son musical est la superposition d’un son fondamental et d’harmoniques dont les fréquences sont des multiples de la fréquence fondamentale.

Un son ne comprenant qu’une seule fréquence est appelé son pur ( il est sinusoïdal et extrêmement rare dans notre environnement quotidien). Les sons musicaux sont des sons complexes, car on y trouve un mélange de sons graves et de sons aigus. Le son musical est la superposition d’un son fondamental et d’harmoniques dont les fréquences sont des multiples de la fréquence fondamentale.

Donc pour finir, la richesse en harmonique d’un instrument détermine le timbre de celui-ci.

Différence de timbre entre deux instruments:

II) NOTRE PERCEPTION DES ONDES SONORES.

Dans cette deuxième partie de

notre TPE, nous verrons comment l’être humain perçoit les ondes sonores. C’est

notre oreille qui en est responsable. Nous suivrons le trajet de ces ondes

sonores de son milieu de propagation jusqu’ à notre cerveau.

L’oreille est un organe

extrêmement sensible qui permet la perception des ondes sonores, vues

précédemment. Ce récepteur auditif est constitué de plusieurs parties, on

distingue :

- - L’oreille externe

- - L’oreille moyenne

- - L’oreille interne

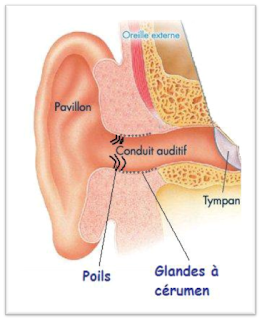

Coupe de l’oreille. On aperçoit les trois grandes parties ainsi que les

principaux éléments les constituant.

Chacune des parties a un rôle

particulier qu’on traitera dans cette partie de notre dossier. Nous suivrons le

trajet de l’onde sonore à travers ces différents niveaux.

Cette onde sonore passe tout

d’abord par l’oreille externe.

A) L'oreille externe

L’oreille externe sert à la fois

de structure de protection et de résonance. Notre oreille externe capte les

ondes sonores. Elle sert de conduit qui guide les sons environnants vers le

système auditif. Le pavillon capte les ondes sonores, puis le transmet par

l’intermédiaire du conduit auditif jusqu’au tympan (les ondes sonores suivent

un trajet rectiligne). Les ondes sonores viennent ensuite frapper le tympan. Le

tympan est la limite de l’oreille externe.

L'oreille externe est constituée de 2 éléments principaux:

1)Le pavillon

Le

pavillon est la partie

extérieure de l’oreille, et est en forme de coquille. Cette partie de

l’oreille est constituée d'un cartilage recouvert de peau. Il est

constitué de nombreux replis qui captent les sons et les dirigent. Il joue également le rôle d'amplification.

2)Conduit auditif externe

Le conduit auditif externe est un

tuyau faisant suite au pavillon et qui dirige les ondes sonores provenant de

l’extérieur (du pavillon) vers le tympan. Le conduit auditif a une forme

oblique et mesure de 2 à 4cm de longueur et a un diamètre compris entre 0.5 et

1cm. Il est constitué d’un tissu fibro-cartilagineux dans sa partie externe et

osseux dans sa partie interne. Il amplifie également les sons ayant une fréquence comprise entre 2.5 et 4KHz.

Coupe de l'oreille externe

B) L' oreille moyenne

L'onde sonore traverse tout d'abord le conduit auditif , à la fin de celui-ci les ondes sonores frappent la membrane du tympan qui se met alors à osciller à la fréquence équivalente à celle de l'onde sonore. ( Elle a une capacité de vibration comprise plus ou moins entre 20 et 20 000Hz selon l'individu et son age). Cela se fait à la limite entre l'oreille externe et l'oreille moyenne.

L'oreille moyenne est une cavité contenant de

l'air, appelée la caisse du tympan. Elle est située dans l'os temporal

et est délimitée de l'oreille externe par le tympan et de l'oreille

interne par la fenêtre du vestibule (ovale). L'oreille moyenne comprend donc la trompe

d'Eustache et la caisse du tympan. Cette dernière est constituée des

trois osselets ( marteau, enclume et étrier ) qui sont "reliés" au

tympan.

Le premier osselet lié au tympan est

le marteau. La

tête du marteau, s'articule avec l'enclume, qui est le 2ème

osselet de l'oreille moyenne. A son tour, l'enclume s'articule avec

l'étrier, dernier osselet. Ils sont donc liés entre eux par des ligaments. Lorsque l'on entend un son, la membrane transmet ses vibrations à travers cette structure. C'est en suivant ce

chemin d'osselets que les vibrations de l'air se transmettent de

l'oreille externe jusqu'à l'oreille interne de façon mécanique ( l'étrier transmet les vibrations jusqu'à la fenêtre ovale, qui correspond à l'entrée de l'oreille interne ).

Ces trois osselets ont plusieurs fonctions: elles transmettent

mécaniquement les oscillations du tympan jusqu'à l'oreille interne,

elles accomplissent le rôle d'impédance ( résistance d'un milieu lors du

passage d'un son ) et le rôle d'amplification sonore mécanique et même

d'atténuation. C'est le muscle du marteau qui a un rôle d'amplification

des ondes sonores. Le muscle de l'étrier peut au contraire, en se

contractant, bloquer les vibrations trop importantes ( graves et intenses

) qui pourraient

devenir dangereuses. Ce phénomène s'appelle

le réflexe stapédien et il atténue le son d'environ 10 à 15 dB.

Un dernier élément se situe au niveau de l'oreille moyenne:

c'est la trompe d'Eustache. Cette trompe d'Eustache est un conduit qui

relie l'oreille moyenne à la partie supérieure de la gorge, le

nasopharynx. La trompe d'Eustache ( membraneuse ) assure l'aération de

la caisse du tympan et a pour but de maintenir dans la caisse une

pression égale à celle qui existe sur la face externe du tympan (

pression atmosphérique ).

L'oreille moyenne est l'intermédiaire entre l'oreille

externe et l'oreille interne. Elle communique avec l'arrière bouche par

la trompe d'Eustache et avec l'oreille interne par la fenêtre ronde et

la fenêtre ovale. Elle est séparée du conduit auditif par la membrane du

tympan de 1/10ème de mm d'épaisseur.

L'oreille moyenne humaine

C) L'oreille interne

L'oreille interne est située dans l'os temporal et commence à la fenêtre ovale. Elle est constituée de nombreuses cavités et de petits conduits. Elle assure 2 rôles différents: d'une part la fonction de l’équilibre et d'autre part l'audition. C'est cette dernière fonction qui va nous intéresser.

- Le labyrinthe osseux, qui est constitué de canaux creusés dans l'os. A l'intérieur on retrouve des éléments tels que le vestibule ( l'utricule et la saccule ), la cochlée qui abrite l'organe de l'audition et enfin les canaux semi-circulaires. On retrouve dans ce labyrinthe un liquide péri-lymphatique ( dans les rampes vestibulaire et tympanique ).

- Le labyrinthe membraneux, quant à lui est situé dans le labyrinthe osseux. Ses formes sont donc semblables à celle du labyrinthe osseux. Le liquide contenu à l'intérieur est le liquide endolymphatique (contenu dans le canal cochléaire).

Elle est composée de 2 labyrinthes:

En ce qui concerne la fonction de l'équilibre du vestibule, l'utricule détecte les mouvements d’accélération horizontaux, la saccule permet de percevoir les déplacements verticaux et les canaux semi-circulaires assurent la perception des mouvements de rotation. Le vestibule et les canaux semi-circulaires sont donc des organes d'équilibre.

- Le labyrinthe membraneux, quant à lui est situé dans le labyrinthe osseux. Ses formes sont donc semblables à celle du labyrinthe osseux. Le liquide contenu à l'intérieur est le liquide endolymphatique (contenu dans le canal cochléaire).

Le rôle des liquides contenus dans les 2 labyrinthes est de transmettre les vibrations sonores.

Schéma de l'oreille interne

Passons à présent à l'étude la partie associée à la

perception, la cochlée (limaçon ). C'est une cavité spirale qui

ressemble à une coquille d'un escargot, elle mesure environ 35 mm de long

et 3mm de diamètre au niveau de sa première spirale.

Coupe de la cochlée

La cochlée est divisée en trois parties distinctes:

- le canal cochléaire, canal membraneux situé à l'intérieur de la cochlée

- la rampe tympanique, reliée à la fenêtre ronde

- la rampe vestibulaire reliée à la fenêtre ovale

Répartition des fréquences des sons perçus au niveau de la cochlée. La fréquence 20Hz correspond à l'hélicotrème, ou l'apex ( sommet de la cochlée ).

Elles ont des rôles différents. Les cellules ciliées externes servent à amplifier des vibrations locales tandis que les cellules internes se chargent de la transduction ( le transfert d'une information génétique à partir d'une cellule vers une autre ) afin de converger l'information vers le nerf auditif, relié au cortex. Plus précisément un influx nerveux ( sous forme d'énergie électrique ) sera envoyé vers le cortex auditif, où l'information sera traitée.

Établissons le trajet précis de l'onde sonore à l'intérieur de l'oreille interne:

- Suite à cela, la membrane basilaire se déplacera, ce qui fera incliner les cellules ciliées internes et ces cellules nerveuses percuteront alors la membrane tectoriale. C'est à partir de cette membrane que les informations seront transmises sous forme d'un influx nerveux via le nerf auditif ( plus précisément par nerf cochléaire ) jusqu'au cortex auditif.

Cependant ce "trajet" n'est valable que pour les sons ayant une intensité supérieure à 50dB.

En ce qui concerne les sons d'une intensité inférieure à 50dB, sous l'effet du mouvement de la fenêtre ovale ( mouvement du liquide contenu dans la rampe vestibulaire), la membrane basilaire se déforme mais ce ne sera pas suffisant pour faire incliner les cellules ciliées internes. Dans ce cas, les cellules ciliées externes se contracteront afin de déplacer la membrane tectoriale. Un message nerveux sera alors envoyé vers le cortex auditif qui interprétera le message.

L'ensemble du trajet des ondes sonores à partir du milieu de propagation jusqu'au cortex auditif peut se résumer grâce au graphique suivant:

III) ENREGISTREMENT D'UN SIGNAL ACOUSTIQUE

L’enregistrement est l’opération qui permet de passer d’un son (acoustique) à un signal (électrique). Cette transformation permet, par exemple de diffuser un son acoustique grâce à des enceintes ou de le stocker sur un support, afin de pouvoir le réécouter plus tard.

A) Méthodes et techniques d’enregistrement

La

première forme d’enregistrement sonore fut l’enregistrement mécanique,

le phonautographe inventé par le français Edouard-Léon Scott de

Martinville en 1857. Le phonautographe se composait d’un pavillon

succédé par un diaphragme qui avait pour but de recueillir les

vibrations acoustiques. Ces vibrations étaient par la suite transmises à

un stylet qui les retranscrivait sur une feuille de papier enduite de

noir de fumée. Le phonautographe enregistrait alors les signaux sonores

acoustiques, sur le papier enroulé autour d’un cylindre, mais sans

pouvoir les retransmettre afin de les réécouter. Cependant en 2008 les

données de vibrations enregistrées sur un exemplaire d’un de ces rouleaux

datant de 1860 ont été traitées numériquement dans le but de réécouter

l’enregistrement d’ Au clair de la lune, une chanson de l’inventeur. Ce serait le plus ancien enregistrement sonore de l’humanité.

Mais c’est en 1877, suite au brevet déposé par Thomas Edison pour l’invention de son phonographe que l’enregistrement mécanique est devenu populaire. En effet, ce dernier invente un appareil semblable à celui de Scott sauf que le sien aggrave les vibrations dans un cylindre grâce à un stylet pointu (comme une aiguille inventé par Charles Cros), pour que lorsque le cylindre tournait dans l’autre sens, l’aiguille repassait par les sillons qu’elle avait creusé et transmettait ces vibrations au pavillon (qui émettait le son traduit des sillons) grâce à une membrane de mica qui faisait office de diaphragme. C’est Emile Berliner qui proposa la même année d’utiliser un disque en vinyle à la place du cylindre.

La

deuxième technique d’enregistrement qui succéda cette première fut

l’enregistrement électromagnétique. C’est grâce à l’arrivée de

l’électricité et de la maîtrise des champs électromagnétiques que les

scientifiques de l’époque réussirent à stocker tout d’abord leurs

enregistrements sur un fil métallique puis sur une bande magnétique.

Cette forme d’enregistrement implique l’invention du microphone. Cet

« accessoire » sera à la source de la transformation du signal

acoustique sonore en un signal électrique. C’est également cet appareil

(le microphone) qui ouvrit la porte aux enregistrements multipistes avec

plusieurs microphones branchés simultanément enregistrant chacun un

signal ou encore au mixage et au montage du son, c'est-à-dire

l’arrangement d’un enregistrement. A la fin de l’enregistrement (qui a

pu subir un arrangement) les signaux sonores sont stockés sur différents

types de supports comme la bande magnétique, le disque microsillon, la

cassette (K7) ou enfin plus tard le disque compact (CD).

Grâce à ces nouveaux supports, cette technologie (enregistrement électromagnétique) sera très diffusée et participera donc à l’essor commercial de la musique enregistrée.

Grâce à ces nouveaux supports, cette technologie (enregistrement électromagnétique) sera très diffusée et participera donc à l’essor commercial de la musique enregistrée.

B) Les appareils intervenant lors d’un enregistrement, en détails

Ensuite, un amplificateur (ou préamplificateur) est nécessaire lors de l’enregistrement. Celui-ci va assurer la qualité de l’enregistrement et doit être proche de l’appareil de captation (dans la chaine des dispositifs). Pour le phonautographe c’était le pavillon qui jouait ce rôle, le pavillon pouvait être comparé à un entonnoir puisqu’il rassemblait l’ensemble des ondes sonores en un endroit précis sur la membrane (ou diaphragme) afin d’assurer un tracé précis au niveau du cylindre. De nos jours, lors de l’utilisation d’un microphone pour un enregistrement électromagnétique, l’amplificateur est placé « derrière » le dispositif de captation. L’amplificateur doit extraire un faible signal électrique, au milieu de parasites, dans l’ensemble des ondes sonores traduites en signaux électrique par le micro et limiter la dégradation du signal sonore lors du « trajet de l’onde sonore dans le microphone ». Il est donc le dispositif qui assure la clarté du son et la fidélité entre l’onde sonore et le signal électrique. Il existe plusieurs types de préamplificateur comme les préamplificateurs à transistors qui amplifient principalement grâce à des éléments en silicium ou les préamplificateurs à lampe basés, comme le nom l’indique, sur un filament incandescent.

Figure 2 Pré-amplis à lampe Figure 1 Pré-amplis à transistors

Enfin, il faut stocker l’enregistrement sur un support. En

effet les signaux électriques ou les vibrations captées par le

phonautographe doivent être mis en mémoire afin de permettre une

réécoute des ondes sonores acoustiques enregistrées.

Cette étape d’écriture est celle qui clôture l’enregistrement, elle

doit être réalisée avec une très grande attention et doit être

précisément préparée. Pour un enregistrement durable, on préfère choisir

un support analogique comme la bande magnétique ou le disque vinyle et

les supports numériques comme le disque compact.

C) Quelques différents supports de stockage

1°) Le vinyle :

Voilà le tracé que produit un diamant de phonographe sur un vinyle lorsqu’il va capter une onde sonore. Comme vu précédemment, c’est quand le diamant repassera par ce sillon qu’il transmettra un signal sonore au diaphragme qui l’émettra grâce au pavillon.

2°) La bande magnétique (cassette) :

Nous

pouvons observés des zones claires et des zones sombres : ce sont des

particules magnétiques (métal, oxyde de fer, maghémite ou oxyde de

chrome (CrO2)). Leurs couleurs différencient leur

orientation. Ces particules s’orientent selon leur champ magnétique et

cela code les informations de l’enregistrement. Ce type de support est

donc assez fragile en présence de grand champ magnétique ambiant. C'est par exemple le cas d'un aimant lorsqu'il est posé à coté d’une cassette de

ce type.

3°) Le disque compact (cd) :

Ce

support est quant à lui « gravé » grâce à un laser optique. Ce laser

va creuser des alvéoles en partant du milieu du disque jusqu’à ses

extrémités, contrairement au vinyle. Le signal sonore va être codé par un

« 1 » ou un « 0 », le « 1 » correspond à un creux et le « 0 » à une

bosse (absence d’alvéole/creux). La taille de ces alvéoles sera

comparable à celle d’un grain de sable si le CD était agrandi aux

dimensions d’un stade de football.

De

nos jours, ce type de support est très utilisé pour les signaux

numériques. Par exemple un microphone branché à un PC transmet

ces signaux électrique (analogiques) à la carte son de ce dernier qui va

les traduire en signaux numériques.

Cette nouvelle « transformation » va permettre aux signaux sonores d’être découpés voir remasterisés (pour les vieux enregistrements) en étant traités numériquement.

IV) LE TRAITEMENT DU SON

A) L’échantillonnage :

L’échantillonnage

consiste à numériser un son, ou document sonore, en enregistrant

différentes parties du spectre sonore d’un son analogique. Nous voyons

donc avec l’exemple ci-dessous deux exemples d’échantillonnage d’un son.

Nous

pouvons voir que plus il y a d’échantillons, et plus le son numérique

sera fidèle au son d’origine. Pour choisir la fréquence

d’échantillonnage, il faut se référer aux sons : en effet, plus un son

est aigu et plus il lui faudra d’échantillons en raison de son spectre

par rapport à celui d’un son grave (voir ci-dessous)

Nous pouvons donc dire que plus la fréquence d’échantillonnage est élevée et plus le son numérique sera proche du son original.

B) Qu’est-ce que la quantification et à quoi sert-elle ?

La

résolution permet d’avoir un son plus proche de l’original. En effet

plus les bâtons du diagramme sont proches de la courbe analogique et que

le son sera donc plus précis et fidèle à l’original (voir ci-contre)

Nous

pouvons bien voir ici que le graphique de gauche est moins fidèle à la

courbe analogique alors que les bâtons du graphique de droite se

rapprochent plus de la courbe. Ce phénomène est du à la résolution : à

gauche, nous avons une résolution de 8 bit alors qu’à droite nous avons

un résolution de 16 bit, ce qui signifie que les bâtons seront plus

proches de la courbe, et que le son sera plus net et proche du son

d’origine.

La quantification, elle,

est une seconde phase qui consiste à prélever des points de l’amplitude

sur la courbe originale et ensuite d’arrondir ces chiffres à l’entier le

plus près (voir ci-dessous).

C) Les différents formats de fichier son.

Il

existe de nos jours différents formats de fichier son, avec des

fichiers non compressés et des fichiers compressés. Le fait de

compresser un fichier permet à ce dernier de devenir plus léger,

c'est-à-dire de prendre moins de place dans un disque dur ou permettre

un temps de téléchargement sur Internet plus rapide.

Il existe deux principaux types de compression :

-

Tout d’abord, nous allons parler de la compression sans perte (fichier

.zip .cab .rar .ace .7z .tar .gzip). C’est une opération de codage qui

consiste à changer des bits A en bits B qui possèdent un codage pour

rendre les informations compressées plus courtes que les originales,

mais tout en gardant les même informations. L’avantage de la compression

sans perte est de pouvoir toujours garder les mêmes informations donc

la même suite de bits, après des compressions et des décompressions. Ce

type de compression est donc utilisé pour les fichiers importants pour

pouvoir garder les mêmes informations. Le but de ces fichiers est de

réduire la taille du texte mais tout en gardant le texte d’origine qui

est compacté, mais qui peut à tout moment retrouvée sa forme d’origine.

-Mais

il existe aussi des fichiers compressés avec pertes, qui peuvent être

utiles pour d’autres fichiers. Les algorithmes lors des compressions et

des décompressions successives changent mais restent sensiblement les

mêmes, ce qui peut être utiles pour tous les fichiers comme les images

ou bien comme les fichiers son. En effet, ces fichiers sont compressés

avec des algorithmes différents et ne pourront pas retrouvés leur forme

d’origine. Mais la compression de ces fichiers est basée sur des détails

que l’humain ne peut pas percevoir. Pour les fichiers son, la

compression avec perte peu supprimée certains son d’une musique pas

exemple, mais ces derniers ne sont pas perceptibles par l’oreille

humaine. C’est pour cela que la majeure partie des fichiers images ou

son sont des fichiers compressés avec perte. Les fichiers peuvent être

donc considérés comme identiques pour l’œil ou l’oreille humaine.

Conclusion

En conclusion, nous pouvons dire que ces recherches sur le son ont permis dans un premier temps de créer des appareils pouvant enregistrer des sons, puis dans un second temps, avec les avancées technologiques de pouvoir stocker des sons avec des fichiers son, qui peuvent être plus ou moins précis, et garder un son numérique plus fidèle que l’original, ou bien avec des fichiers moins lourds, mais avec de la perte (un son donc moins fidèle que le son original mais qui peut très bien convenir suivant son utilisation). Nous pouvons aujourd’hui dire que toutes ces avancées on été possible grâce aux connaissances sur l’oreille et son fonctionnement.